Sora可能会彻底改变视频制作领域,并放大虚假信息的风险。

Sora 目前还未正式对外上线。后续预计先在 ChatGPT Plus 会员覆盖。还没有开通ChatGPT Plus会员的可以参考下面这篇文章开通手把手教你开通ChatGPT Plus会员,需要代充或者账号购买的也可以联系站长微信:Chatwin8

上个月,OpenAI宣布了一种名为Sora的新型生成式AI系统,该系统能够根据文本提示生成短视频。尽管Sora目前尚未向公众开放,但到目前为止发布的样本输出的高质量已引发了兴奋和关切的反应。

OpenAI发布的样本视频显示了由Sora直接创建的输出,公司表示这些视频没有经过修改。这些视频来自于如“一杯咖啡里两艘海盗船战斗的逼真特写视频”和“加利福尼亚淘金热时期的历史影像”等提示。

乍一看,很难分辨出这些视频是由AI生成的,因为视频的质量、纹理、场景动态、摄像机运动和一定程度的连贯性都很高。

OpenAI首席执行官Sam Altman还在X上发布了一些根据用户建议的提示而生成的视频,以展示Sora的能力。

(PS:目前 openai 官方还未开放 sora 灰度,不过根据文生图模型 DALL·E 案例,一定是先给 ChatGPT Plus 付费用户使用,需要注册或者升级 GPT Plus 可以看这个教程:ChatGPTPlus升级教程 )

Sora如何工作?

Sora结合了文本和图像生成工具的特点,采用了所谓的“扩散变换模型”。

变换模型是一种由谷歌在2017年首次引入的神经网络类型。它们最著名的应用是在大型语言模型中,如ChatGPT和Google Gemini。

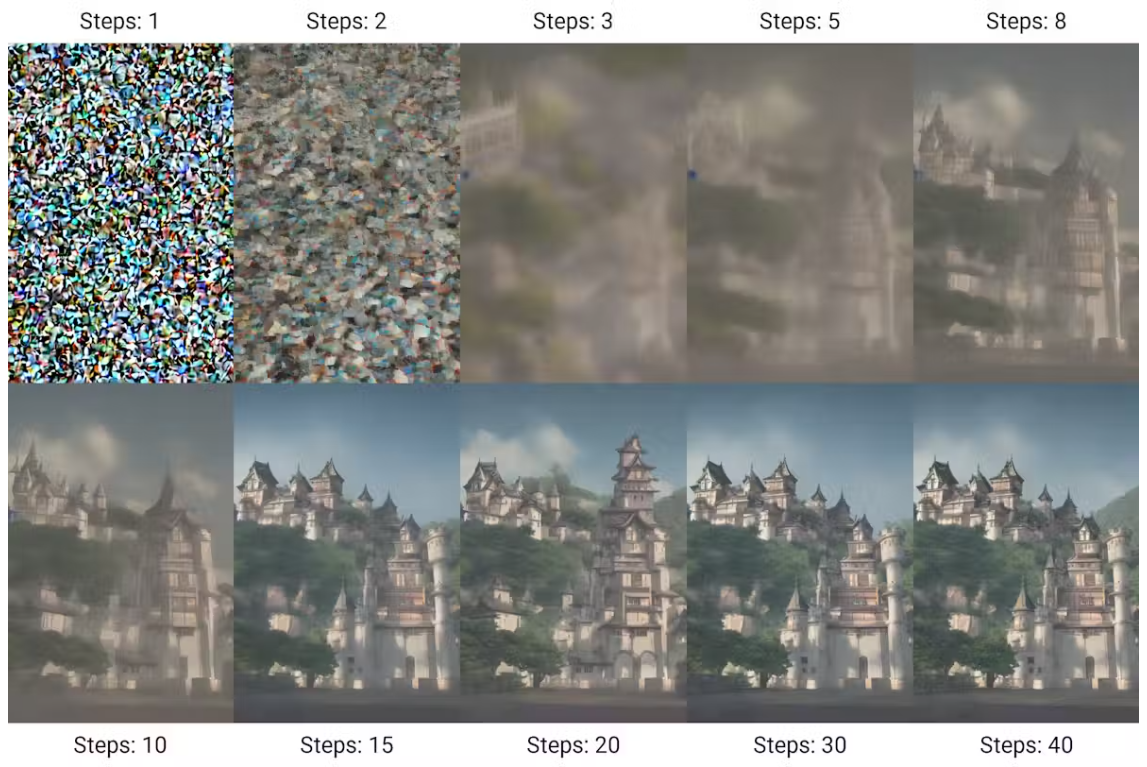

另一方面,扩散模型是许多AI图像生成器的基础。它们的工作原理是从随机噪声开始,逐渐迭代出符合输入提示的“清晰”图像。

一个系列的图片显示了一座城堡从静态中浮现出来。扩散模型(在这个例子中是稳定扩散)通过多次迭代从噪声中生成图像。

通过这样的图像序列可以制作视频。然而,在视频中,帧之间的连贯性和一致性至关重要。

Sora使用变换架构来处理帧之间的关系。虽然变换器最初是为了找出代表文本的标记中的模式而设计的,但Sora却使用代表小块空间和时间的标记。

领先群雄

Sora并不是第一个文本到视频的模型。早期模型包括Meta的Emu、Runway的Gen-2、Stability AI的Stable Video Diffusion,以及最近Google的Lumiere。

Lumiere在几周前发布,宣称能产生比其前辈们更好的视频。但Sora在某些方面似乎比Lumiere更强大。

Sora可以生成分辨率高达1920×1080像素的视频,并支持多种纵横比,而Lumiere的分辨率限制为512×512像素。Lumiere的视频长度约为5秒,而Sora可以制作长达60秒的视频。

Lumiere无法制作由多个镜头组成的视频,而Sora可以。Sora和其他模型一样,也据说能够执行视频编辑任务,如从图像或其他视频创建视频、结合不同视频的元素、以及在时间上延长视频。

这两种模型都能生成大致逼真的视频,但可能会出现幻觉。Lumiere的视频可能更容易被识别为AI生成。Sora的视频看起来更具动态性,元素之间的互动更多。

然而,在许多示例视频中,仔细观察会发现一些不一致之处。

有前景的应用

目前,视频内容是通过拍摄现实世界或使用特效制作的,这两种方式都可能成本高昂且耗时。如果Sora以合理的价格推出,人们可能会开始将其作为原型软件使用,以更低的成本将想法可视化。

根据我们对Sora能力的了解,它甚至可能被用于娱乐、广告和教育等领域的短视频制作。

OpenAI关于Sora的技术论文题为《Video generation models as world simulators》。该论文认为,像Sora这样的视频生成器的更大版本可能是“物理和数字世界及其中的物体、动物和人的有效模拟器”。

如果这是正确的,未来版本可能在物理、化学甚至社会实验方面有科学应用。例如,可以测试不同大小的海啸对不同类型基础设施的影响,以及对附近人们的身心健康的影响。

实现这种级别的模拟非常具有挑战性,一些专家认为像Sora这样的系统根本无法做到。

一个完整的模拟器需要在宇宙的最细致层面计算物理和化学反应。然而,在未来几年内,模拟出一个大致的世界并制作出对人眼来说逼真的视频可能是可行的。

风险和伦理问题

围绕像Sora这样的工具的主要担忧是其社会和伦理影响。在一个已经被假信息包围的世界中,像Sora这样的工具可能会使情况更糟。

可以想象,生成任何你能描述的场景的逼真视频的能力可能被用来传播令人信服的假新闻或对真实影像产生怀疑。它可能会危及公共卫生措施,用于影响选举,甚至给司法系统带来潜在的假证据的负担。

视频生成器也可能直接威胁到特定个体,特别是色情深度伪造作品。这些可能对受影响个人及其家庭的生活产生可怕的后果。

除了这些担忧之外,还有版权和知识产权的问题。生成式AI工具需要大量的数据进行训练,OpenAI尚未透露Sora的训练数据来自何处。

大型语言模型和图像生成器也因此受到批评。在美国,一群著名作家起诉了OpenAI,因其可能滥用他们的材料。该案件认为,大型语言模型及使用它们的公司在创造新内容时窃取了作者的作品。

尽管这些担忧是真实的,但根据过往经验,我们不希望它们会阻止视频生成技术的发展。OpenAI表示,在向公众开放Sora之前,它正在“采取几项重要的安全措施”,包括与“虚假信息、仇恨内容和偏见”的专家合作,以及“构建工具来帮助检测误导性内容”。

本文来源:THE CONVERSATION